教程/Mac mini M4丐版/部署Ollama/docker open-webui/qwen2.5/DeepSeek r1/单机版AI Chat

2月6日更新• Chat AI • Deepseek r1 • Mac mini M4 • Ollama • open-webui • qwen2.5 • 单机版AI•教程•阅读:4,440次

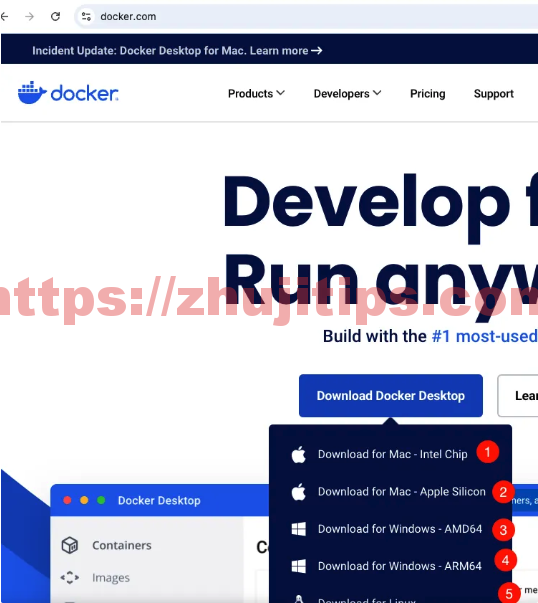

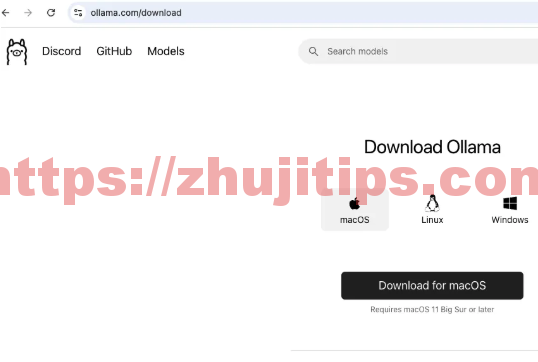

Mac mini M4选择第2个下载

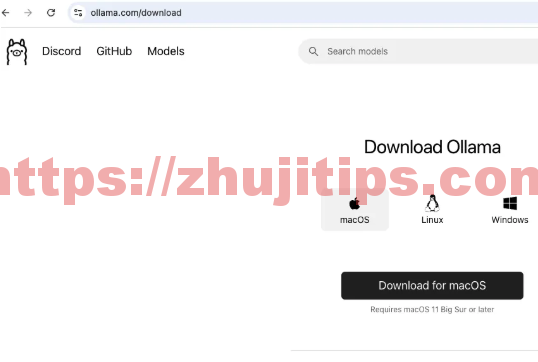

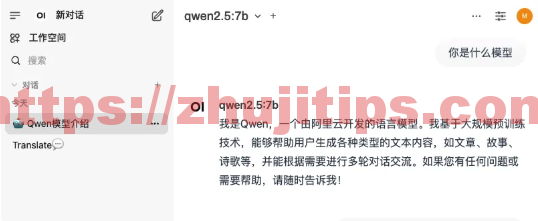

1.安装Ollama

下载

根据提示,安装Ollama

启动Ollama app

2.安装docker

根据提示,安装docker

启动docker app

3.安装docker版open-webui(ui界面)

https://github.com/open-webui/open-webui

使用默认配置进行安装(博主macOS mini m4,使用了第一条)

-

如果您的计算机上有 Ollama,请使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main -

如果 Ollama 位于不同的服务器上,请使用以下命令:

要连接到另一台服务器上的 Ollama,请更改

OLLAMA_BASE_URL为该服务器的 URL:docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main -

要运行支持 Nvidia GPU 的 Open WebUI,请使用以下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

仅供 OpenAI API 使用安装

-

如果您仅使用 OpenAI API,请使用此命令:

docker run -d -p 3000:8080 -e OPENAI_API_KEY=your_secret_key -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

安装附带 Ollama 支持的 Open WebUI

此安装方法使用将 Open WebUI 与 Ollama 捆绑在一起的单个容器映像,从而允许通过单个命令进行简化设置。根据您的硬件设置选择适当的命令:

-

借助 GPU 支持:通过运行以下命令来利用 GPU 资源:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama -

仅适用于 CPU:如果您不使用 GPU,请改用以下命令:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

这两个命令都有助于 Open WebUI 和 Ollama 的内置、无忧安装,确保您可以快速启动并运行一切。

安装后,您可以通过http://localhost:3000访问 Open WebUI 。尽情享用吧!

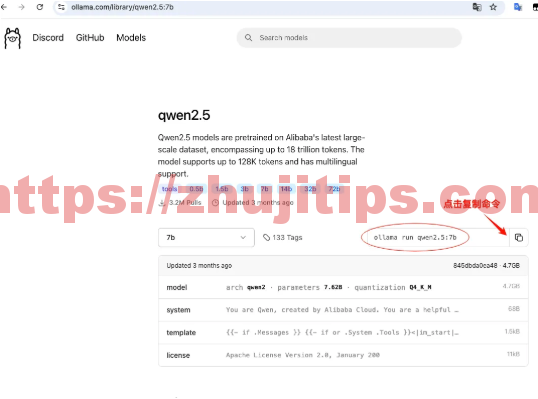

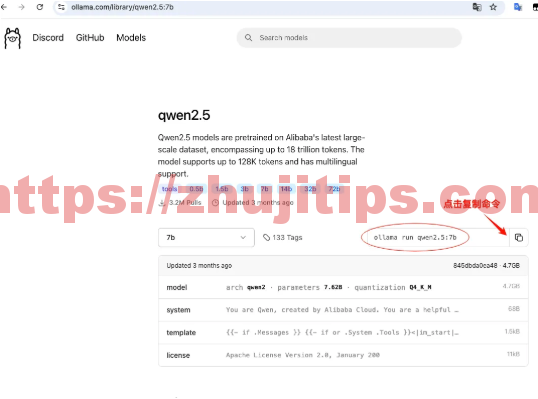

4.下载Ollama模型

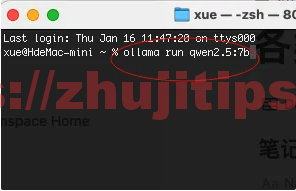

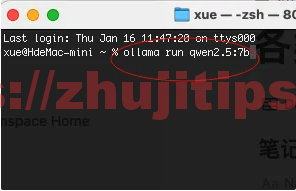

在终端中运行该命令

看进度条,等待下载完成后,即可。

同样,deepseek r1,终端运行

ollama run deepseek-r1:7b

mac mini m4丐版,也就能跑跑7b模型,再大就吃力了。

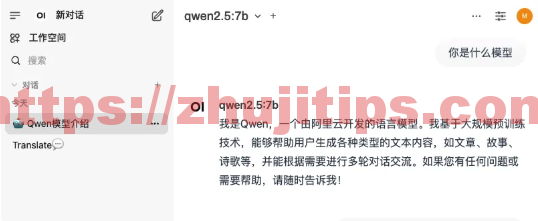

5.运行

首次启用,会让你注册一下(单机版,随便注了)